Como ter (e manter) um banco de dados saudável?

Durante um workshop, o executivo Rajeev Priyardashi, da IBM, disparou a pergunta: por que devo cuidar da minha saúde? E ele mesmo respondeu: porque pretendo correr e brincar com meus netos quando chegar aos 70.

Governança de dados para quê? Devemos investir nisso?

Como fazer o cross sell e vender mais para quem já é cliente? Quem, no nosso imenso banco de dados, está propenso a comprar um novo produto? Que decisão tomar e qual estratégia adotar em relação ao futuro?

O tempo como indicador de performance e experiência do usuário

Num mundo cada vez mais digital, a experiência do usuário com as aplicações é fundamental para a conversão de negócios e cada segundo conta

Com a emancipação das aplicações de negócio, que saíram da retaguarda para atuar na linha de frente do mundo digital, a demanda por uma experiência de usuário que favoreça a conversão de negócios tornou-se imperativa. Nesse sentido, garantir que as jornadas de cliente sejam realizadas nos mais elevados níveis de performance virou diferencial competitivo, sobretudo quando se tem como referencial plataformas globais de redes sociais cujos investimentos em performance são substanciais.

“O que pode ser medido pode ser melhorado.”

Peter Drucker

O primeiro passo para otimizar a performance da experiência digital é a implementação de indicadores que permitam o direcionamento assertivo de esforços. Com esse objetivo, uma aliança de empresas formou um grupo de trabalho ainda em 2004 e criou o APDEX (Application Performance Index). Trata-se de um índice desenvolvido para medir a performance de transações de negócio, que se tornou um padrão “de facto” no mercado de APM (Application Performance Monitoring).

Tempo por somatória

É importante esclarecer que uma transação de negócios é composta pela execução de diversas ações encadeadas. Os tempos de execução de cada uma dessas ações somados, compõem o tempo total da transação e determinam a performance da experiência do cliente.

O APDEX estabelece como premissa a definição de um tempo limite T para o qual uma ação é considerada atendida de forma satisfatória. A partir desta definição inicial, o APDEX define como tolerada, ações executadas com tempo acima de T e até 4 x T. Ações realizadas com tempos acima de 4 x T, são classificadas como frustradas.

Se considerarmos, por exemplo, que 3 segundos seja o tempo máximo para que uma determinada ação seja executada de forma satisfatória, teremos:

execução em até 3s —> satisfatória;

execução acima de 3s e até 12s —> tolerada;

execução acima de 12s —> frustrada.

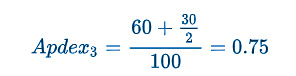

O indicador de performance APDEX é gerado a partir da aplicação da fórmula abaixo, onde a quantidade total de ações que tiveram tempo satisfatório é somada com a metade das ações classificadas como toleradas e divididas pelo total de ações da amostra (incluindo as frustradas).

O APDEX produzirá um resultado entre 0,0 e 1,0, sendo 0 o indicativo de que nenhuma das ações observadas foi executada em tempo satisfatório e 1, todas as ações foram executadas em tempo satisfatório. Ou seja, quanto mais próximo de 1, melhor será o índice de satisfação dos usuários em relação à performance.

Considere que numa amostra de 100 ocorrências e um tempo T de 3 segundos, 60 ações tiveram tempo abaixo de 3s, 30 estão entre 3s e 12s e as 10 restantes foram classificadas como frustradas. Neste exemplo, o cálculo do APDEX seria:

Tempo por aplicação

Tempo por aplicação

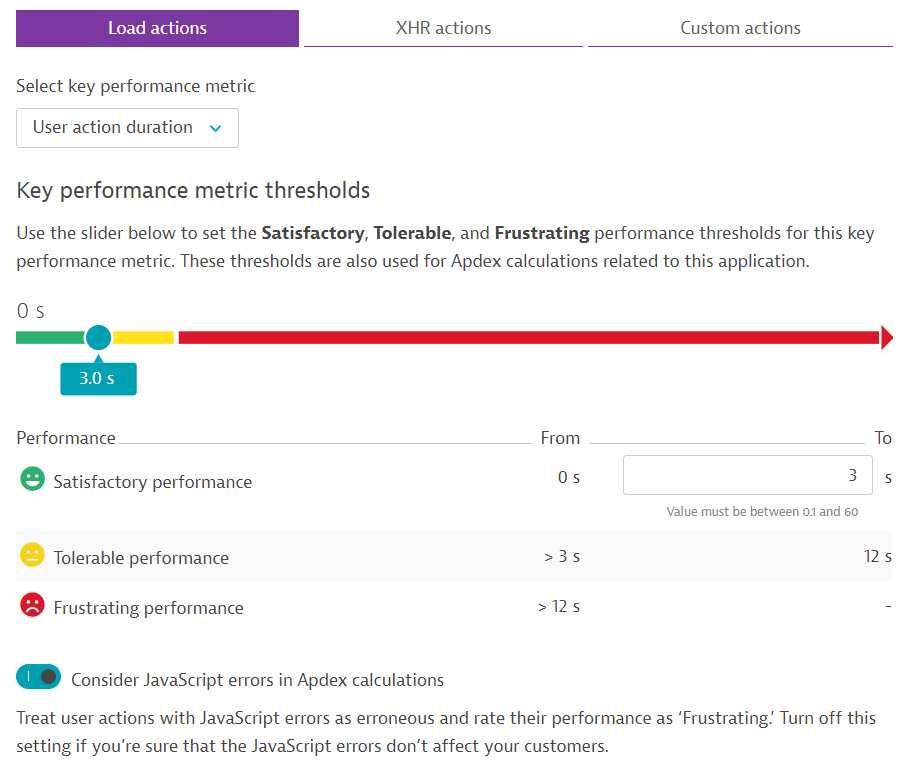

Além de fazer parte do grupo de trabalho que desenvolveu o APDEX, a Dynatrace, líder no quadrante mágico do Gartner para "Application Performance Monitoring", implementa o indicador em sua integralidade em suas soluções de monitoramento, permitindo que o tempo limite T, para que uma ação seja classificada como satisfatória, seja configurado por aplicação e adotando uma iconografia simples e que facilita sua adoção.

Na imagem abaixo, temos a tela de configuração do APDEX por aplicação no Dynatrace. Detalhe: neste exemplo, erros de JavaScript serão considerados como experiência frustrada.

Classificação Dynatrace

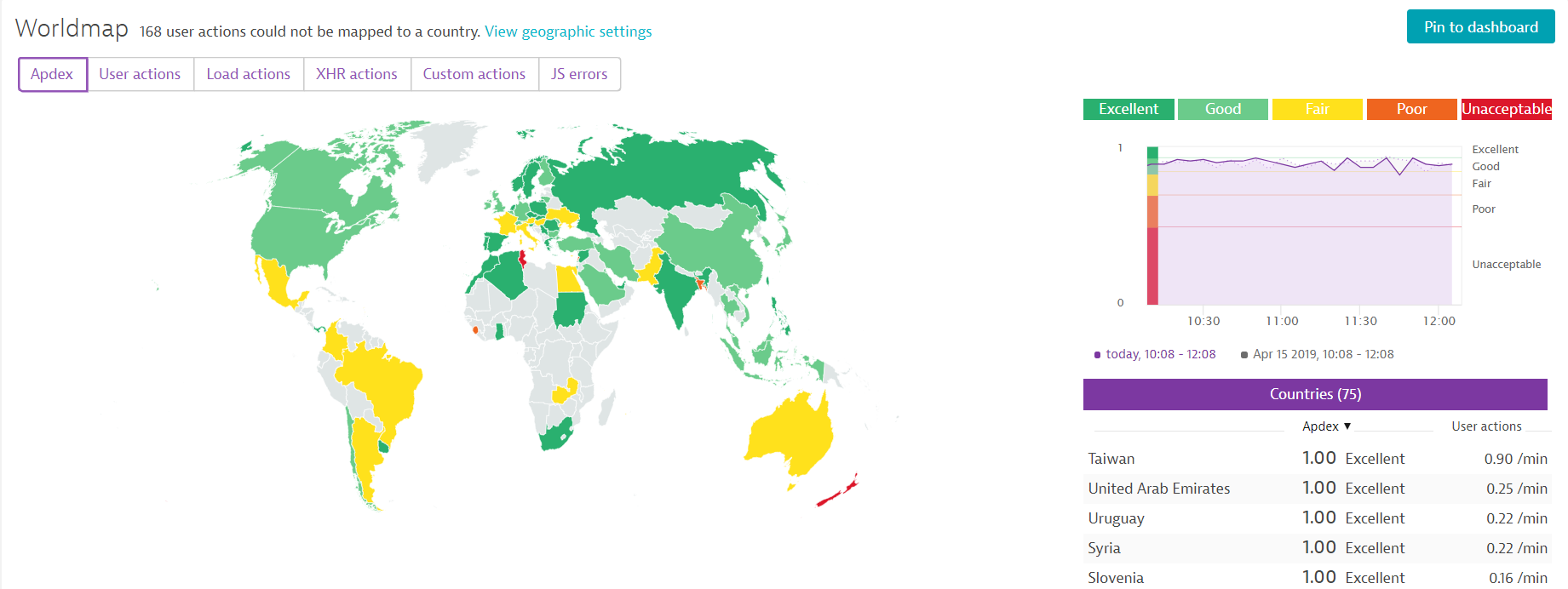

Para simplificar a avaliação do resultado do indicador de performance (valor entre 0 e 1), a Dynatrace sugere a seguinte classificação:

APDEX igual a 1,0 --> Excellent (cor verde escuro)

APDEX igual ou superior a 0,85 --> Good (cor verde claro)

APDEX igual ou superior a 0,70 --> Fair (cor amarela)

APDEX inferior a 0,70 --> Poor (cor laranja)

APDEX inferior a 0,5 --> Unacceptable (cor vermelha)

Este tipo de classificação permite a visualização de dashboards, como o exemplo da imagem abaixo, onde a experiência de performance dos usuários de uma aplicação pode ser classificada por localidade de acesso e a visualização é feita através de cores:

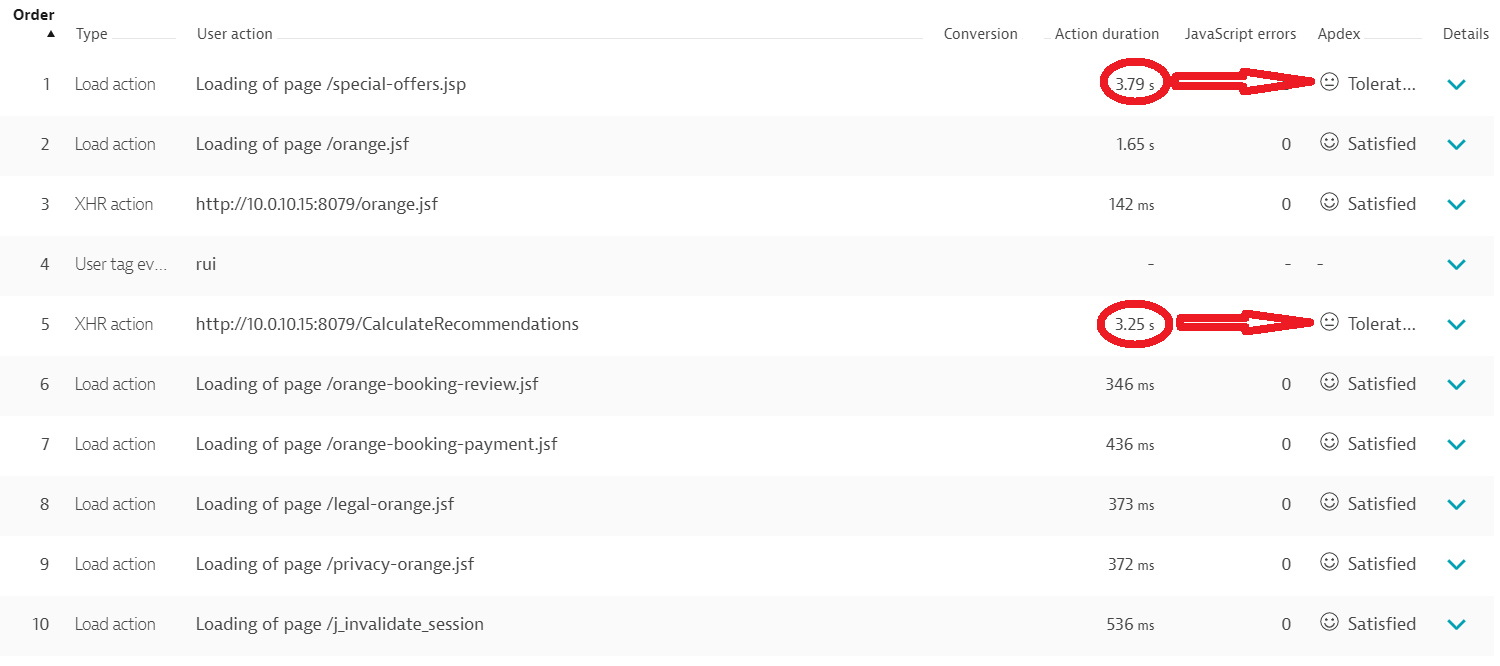

Um outro exemplo do emprego do APDEX pela Dynatrace é a classificação da performance para cada ação do usuário ao longo de sua jornada na aplicação. Desta forma, é possível determinar quais etapas estão contribuindo com os maiores tempos para a experiência do cliente, como pode ser visto na figura abaixo, onde pode-se ver a classificação da performance de cada ação do usuário ao longo de sua jornada na aplicação:

Nossos especialistas

Nossos especialistas

Quer saber mais sobre como especificar e implementar indicadores de performance para suas aplicações de negócio? Quer descobrir quais métodos de sua aplicação mais oneram o tempo de resposta de suas transações de negócio? Gostaria de engajar suas equipes de sistemas, infraestrutura e desenvolvimento através de dados relevantes acerca da experiência digital de seus clientes?

Nossos especialistas possuem experiência e são capacitados para apoiá-lo na implementação, através de jornadas cumulativas, de uma cultura de monitoramento que forneça prontamente e permanentemente informações relevantes para tomada de decisão estratégica, atuação emergencial em momentos de crise e acompanhamento histórico de saúde e disponibilidade de suas aplicações.

David Gomes

Gerente de serviços

Saiba mais:

APDEX Alliance: https://www.apdex.org/

Documentação do APDEX: https://en.wikipedia.org/wiki/Apdex

Suporte Dynatrace:

https://answers.dynatrace.com/questions/206430/apdex-calculation-for-frustated.html

Saque Pague implementa solução para auditar itens de segurança com mais agilidade e eficiência

Projeto utiliza a distribuição de patches para corrigir os servidores em minutos, alcançando até 98% de sucesso

A Scala realizou um grande projeto na Saque Pague, plataforma de tecnologia detentora de uma rede de autoatendimento, com o objetivo de gerenciar e auditar itens de segurança nos servidores, espalhados nos dois datacenters próprios, um no Brasil e outro no México, de forma ágil e centralizada. Denominada BigFix, a plataforma realiza a distribuição de patches, programas para corrigir vulnerabilidades de segurança, além de gerar relatórios em conformidade com várias auditorias.

Em 2017, a Saque e Pague começou a sua internacionalização com uma operação no México. Com a estabilização do ambiente no México, a companhia necessitava de agilidade para atender todas as normativas financeiras no Brasil, no México e nos novos países foco do seu processo de internacionalização. Já no ano seguinte, começou a busca por uma solução que, de forma centralizada, possibilitasse a distribuição das atualizações, principalmente dos sistemas operacionais, e a geração dos relatórios de auditoria, tais como PCI (Payment Card Industry). Hoje a empresa controla a distribuição dos patches em mais de 200 servidores no Brasil, 50 no México e 250 desktops.

A Saque Pague passou a corrigir todos os servidores em minutos – antes o processo ocorria em algumas horas, com 98% de sucesso na primeira tentativa. Além disso, aumentou a eficiência e reduziu os custos, impulsionando o ROI em toda a empresa; com simplificação do gerenciamento de configuração e distribuição de software nos servidores e automação das correções para sistemas operacionais e aplicativos de terceiros, fornecendo recursos de correção offline, com altos índices de sucesso na primeira tentativa.

Muitos benefícios

Muitos benefícios

“Após a realização da negociação e de uma prova de conceito (POC), fechamos o projeto para a implantação do ambiente de servidores do Brasil e do México, com um console de gerenciamento centralizada pela equipe de segurança do Brasil. Em maio de 2019, já com o ambiente de servidores totalmente em produção, ampliamos o escopo para mais 250 desktops”, explica Filipe Cotait, diretor de tecnologia da Scala.

“Hoje, o ambiente está 100% ativado e é fundamental para automatizar as atividades com segurança e gerar, de forma rápida, uma visão consolidada e detalhada, dependendo das necessidades de cada auditoria”, destaca Antônio Elcir Fonini, responsável pela área de Segurança da Informação da Saque e Pague.

O projeto apresentou muitos benefícios, como o gerenciamento unificado da aplicação de patches em desktops Microsoft Windows e Red Hat Linux; visibilidade de como precisam ser aplicados em determinados dispositivos; redução dos ciclos de gerenciamento de patches, permitindo que a equipe de TI agende as correções conforme sua conveniência, enquanto monitora os resultados da implantação; indicação precisa e atualizada da aplicação contínua da solução nos servidores, bem como a redução do esforço administrativo por meio das ações de automação.

“O ponto crucial da implementação foi a integração entre o Bigfix e as bases de patches Red Hat na nuvem e os servidores Red Hat Satellites. Com a plataforma, foi possível contar com recursos nativos de integração que acelerassem a implementação”, finaliza o diretor de tecnologia da Scala.

Onde investir meu tempo e o meu restrito orçamento?

Os últimos meses trouxeram diversas incertezas e mudanças para o mundo de forma geral. O ambiente dos negócios foi extremamente afetado pelos rumos da pandemia do COVID-19. A velocidade das engrenagens produtivas de um planeta que andava a todo vapor foi diminuída. Economias estão desacelerando e pipelines, forcastes e promessas de resultados estão sendo revistos e, quase sempre, sendo diminuídos.

A única certeza que 2020 nos revela é um conceito antigo, mas sempre atual, relacionado à produtividade de qualquer negócio: fazer mais com menos. Pensar sobre essa ótica, nunca fez tanto sentido para humanidade, que parece viver o fim de um ciclo e o início de outro. Falar sobre isso parece obvio e muitos dirão viver isso as 24 horas do dia. Entretanto, mais do saber esse conceito, é necessário colocá-lo em prática e nesse caminho que gostaríamos de convidá-lo a caminhar nos próximos parágrafos.

Fazer mais com menos sempre foi uma máxima no mundo dos negócios. A tradução de todos os sentidos do conceito de produtividade. Algo que vai muito além de um enorme desejo. Trata-se de uma necessidade, algo de suma importância que em muitos casos é a linha divisória entre o sucesso e o fracasso.

O mundo corporativo sempre foi conduzido sob esse viés e o contexto dos dias atuais, implacavelmente, nos cobra atitudes, ações que sustentam essa máxima. Vai além de um estado contemplativo dos dias atuais. E uma imposição do universo: todo investimento deve ser potencializado ao máximo do aproveitamento, visando a economia e aumento da produtividade. E, independente da sua posição, vertical de negócio, posição política, orientação sexual, time de futebol, a pergunta, ou perguntas, que perfuram seu cérebro, que o mantêm acordado pelas madrugadas e o trouxe até o fim dessa linha é:

– “Onde invisto meu tempo e o meu restrito orçamento?” ou “Como consigo garantir que o negócio se mantenha a todo vapor e ainda encorajo a equipe a seguir com os projetos de inovação?”

Durante um bom tempo ainda comentaremos sobre como éramos antes da pandemia (AP) e como precisamos ser depois dela. Não podemos mais continuar dedicando infinitas horas de gestão e operação em problemas ainda originários em AP. As mudanças não podem esperar. A inovação é a moeda mais forte para combater o momento duvidoso da economia nacional. Ela é o único caminho para reduzir a complexidade, ampliar a gestão da informação e seguir com o cruzeiro de se fazer MAIS COM MENOS.

– E como fazer isso se os orçamentos foram reduzidos?

Uma possível estratégia é dividir a situação em grandes pilares: eficiência, agilidade e produtividade. Se for possível, escolha pelo menos um pilar para justificar o investimento inicial e gerar o ciclo da transformação/inovação. Escolha aquele que pode lhe trazer mais resultados de curto prazo e com isso gerar capacidade para novos investimentos:

- Otimizar a infraestrutura, aplicações, o desenvolvimento e todo o contexto operacional que cresce com o aumento da demanda;

- Olhar a arquitetura do ambiente de TI e sua padronização;

- Otimizar a entrega de novas funcionalidades;

- Automatizar processos de negócio com suporte de robôs;

- Simplificar as integrações e consolidação de informações;

- Bem como fazer uma gestão mais orientada ao cliente, acompanhando toda a sua jornada.

Há inovações que agem minimamente, mas que, em conjunto, conseguem dar mais performance à competitividade da sua empresa no mercado. São os pequenos ganhos em produtividade e em redução de custos que, no final das contas, fazem toda a diferença.

MIRNA MACHADO

Diretora de Produtos e Alianças

MARDEN SOARES

Gerente de Negócios - MG

A digitalização das empresas através da Hiperautomação

A Hiperautomação é um conceito relativamente novo, explorado como tendência pelo Gartner no final de 2019. Como muitos de vocês podem imaginar, a Hiperautomação é proveniente da evolução do que já conhecemos por Automação, mas agrega outras coisas muito importantes além de toda a filosofia de orquestração intrínseca a ela.

Propósito

Algo crucial que precisamos entender e que direcionou o conceito da Hiperautomação, é o propósito por trás disso tudo. A Hiperautomação é centrada nas pessoas. Ela visa alavancar ainda mais o uso e a orquestração de capacidades (assets) digitais com o propósito de assumir grande parte das nossas tarefas operacionais, e ser inteligente para solucionar problemas.

Dentre uma série de assets digitais que podem ser orquestrados dentro de uma jornada de Hiperautomação, dois deles se destacam muito por proporcionarem resultados diretamente alinhados com o propósito em questão:

- RPA, com alto foco na automação de tarefas humanas, repetitivas ou não; e

- iBPMS, em que a automação de processos de negócio pode contar com recursos essenciais baseados em Inteligência Artificial (IA) para ajudar nas tomadas de decisão e na resolução de problemas.

Assets Digitais

Quando analisamos uma determinada operação, área ou processo de negócio de uma organização, rapidamente chegamos à conclusão de que na grande maioria dos casos tudo é realizado por pessoas, e de maneira bastante artesanal e manual.

Significa dizer que as pessoas normalmente priorizam seus afazeres e realizam o seu trabalho utilizando seus próprios controles (planilhas, tasks, sinalizações de e-mails etc.), comunicam-se uns com os outros das mais diferentes formas (e-mail, WhatsApp, telefone, comunicadores instantâneos etc.), sem falar da necessidade de se operar inúmeros sistemas para consultar ou registrar informações inerentes às suas atividades (ALT+Tab, login, senha, menus de aplicação, acesso a relatórios, consultas, gravações etc.).

O trabalho operacional das pessoas é, sem dúvidas, extremamente árduo. Completamente na contra mão do que prega a Hiperautomação: Ajudar as pessoas operacionalmente e nas suas tomadas de decisão, visando à resolução de problemas.

Sabemos que a tecnologia em si facilita a vida das pessoas, e sabemos também que ela pode ser representada por inúmeros recursos digitais, a que me refiro como assets digitais. Podemos exemplificar os assets digitais de diversas formas e tipos, por exemplo:

- Canais digitais e modelos de negócios - Uso da mobilidade, monetização por meio de APIs, Blockchain, ativos alavancados...

- Capacidades digitais - Automação de processos, robotização de atividades humanas, gerenciamento de decisões, gerenciamento de conteúdos digitais, gerenciamento de dados mestre, IA, ML, insights, recomendações analíticas, sistemas...

- Infraestrutura digital - Integração por meio de APIs, uso de uma arquitetura SOA, aptidão para interoperar em hybrid cloud, middleware escalável, low-code, DevOps...

Combinar as capacidades e os assets digitais que fazem sentido ao dia a dia das pessoas e aos processos da organização é o fator chave. Significa pensar na utilização orquestrada desses recursos, visando facilitar a vida das pessoas, e ao mesmo tempo escalar o negócio exponencialmente através da automação – Hiperautomação.

Jornada

O termo jornada aqui cabe bem, e não há receita de bolo que sirva para qualquer desafio ou qualquer organização. É preciso pensar de forma específica a respeito da cadeia de problemas e de oportunidades existente, e também o que se tem à disposição em termos de assets digitais.

Quando pensamos numa jornada de Hiperautomação, buscamos estender os seres humanos com o apoio do trabalho digital que os assets digitais entregam. E isso não é feito da noite para o dia. É preciso ir experimentando e aprimorando essa evolução ao longo do tempo. Partir de um cenário artesanal e manual para um cenário no estado da arte pode levar algum tempo.

Para refletir

Algumas reflexões que podem significar um estímulo para o início de uma jornada de Hiperautomação:

- Faz sentido termos muitas atividades repetitivas e operacionais que não demandam decisão sendo feitas por pessoas?

- A minha operação ou processo disponibiliza um sistema capaz de organizar, priorizar, distribuir e comunicar o trabalho que precisa ser feito pelas pessoas?

- As pessoas precisam operar muitos sistemas ou ferramentas distintas para realizar suas atividades?

- A minha operação ou processo falha com alguma frequência devido ao excesso de trabalho imposto às pessoas?

- As pessoas que atuam na minha operação ou processo sofrem para cumprir regras de negócio e/ou regulamentações?

- Disponho de recursos digitais que podem ser incorporados no dia a dia das pessoas para que elas trabalhem melhor?

A elucubração em torno da Hiperautomação pode ir muito além. As ideias e inovações em torno disso estão diretamente relacionadas com o que conhecemos das nossas operações e processos, e o que dispomos em termos tecnológicos através dos assets digitais.

Um exemplo

Imagine o iBPMS como um asset digital disponível dentro de uma organização, e que em um determinado momento de uma jornada de Hiperautomação, há um processo de negócio automatizado que persiste inúmeros dados operacionais inerentes às tratativas das pessoas que trabalham neste processo.

Poderíamos, por exemplo, utilizar o aprendizado de máquina (ML - Machine Learning) disponível nessa plataforma para que o processo aprendesse com todo o histórico gerado, e que num determinado momento ele fosse capaz de direcionar assuntos específicos para pessoas ou equipes diferentes, ou mesmo resolver casos a partir do conhecimento obtido dos desfechos positivos oriundos de casos resolvidos. Podemos contar com a tecnologia para decidir por nós caso ela tenha um grau de confiança alto a respeito do entendimento de algo, e da recomendação de solução mais apropriada.

Esta nova abordagem permite:

- Explorar novas oportunidades de automação com a utilização da Inteligência Artificial e ML;

- Viabiliza a tomada de decisão autônoma e aprimoramentos contínuos nas operações e processos organizacionais;

- Equilibra tarefas humanas e de máquina para criar uma força de trabalho colaborativa ideal.

Conclusão

A Hiperautomação envolve o uso de uma série de capacidades (assets) digitais que servem ao propósito de ajudar as pessoas, e por consequência habilitam a escalabilidade de negócio das organizações. Esses assets digitais representam a digitalização de diversas operações, serviços, funções, processos, ou mesmo plataformas tecnológicas que a organização dispõe. Com essas capacidades disponíveis digitalmente, operações e processos podem orquestrá-las e consumi-las progressivamente, tornando-se cada vez mais digitais.

Nossa missão ao longo desta jornada é estender os seres humanos com o apoio do trabalho digital para que a sua vida melhore, e permitir que os negócios sejam cada vez mais escalados e alavancados.

Douglas Katoch

Technical Sales Manager

Hiperautomação é uma das top 10 tendências, segundo o Gartner

Ao longo dos últimos anos, a Automação tem sido tema recorrente, uma tecnologia capaz de proporcionar às empresas um salto de produtividade, o que se traduz em redução de custos, mais eficiência e produtividade. Muitas tarefas que exigiam seres humanos passaram a ser feitas por softwares. E, conforme os benefícios foram se revelando, novas iniciativas surgiram.

Automatizar decisões de forma inteligente é possível, combinando o uso de Machine Learning e regras de negócio

As empresas têm conseguido introduzir o poder dos insights analíticos do Machine Learning nas suas operações de negócio, mas integrá-los na automação das decisões necessita implementar uma inteligência artificial explicável (XAI).

Este artigo apresenta o potencial da combinação da escoragem preditiva com a abordagem prescritiva (regras de negócio) para entregar as melhores decisões operacionais. O resultado é um conjunto de regras de negócio que alia uma estratégia de negócio e eventuais restrições regulatórias (lógica determinística) com os insights de um modelo de Machine Learning treinado a partir de dados históricos.

Exemplo prático

No exemplo abaixo, em tempo de execução da regra, um serviço de escoragem considera todos os atributos do cliente que faz parte o contexto da decisão corrente, e a classificação analítica (baixa escoragem de crédito e propensão a desistência baixa ou média) condiciona a aceitação da solicitação daquele cliente.

Se:

- A classificação do cliente é PLATINUM

- A escoragem do crédito do cliente é BAIXA

- Não é verdadeiro que a propensão do cliente a desistir é ALTA

Então,

Aceitar a solicitação do cliente.

Aprendendo a inferir

O Machine Learning é a aplicação de algoritmos de natureza estatística capaz de processar uma grande quantidade de dados contextuais (observações) e dados comportamentais (variáveis resposta), com possibilidade de apreender e inferir um modelo estatístico caracterizado por um conjunto de variáveis inter-relacionadas, que, ao ser estimulado com novos dados, calcula uma escoragem, ou seja, a probabilidade de um determinado fato ocorrer (ou não).

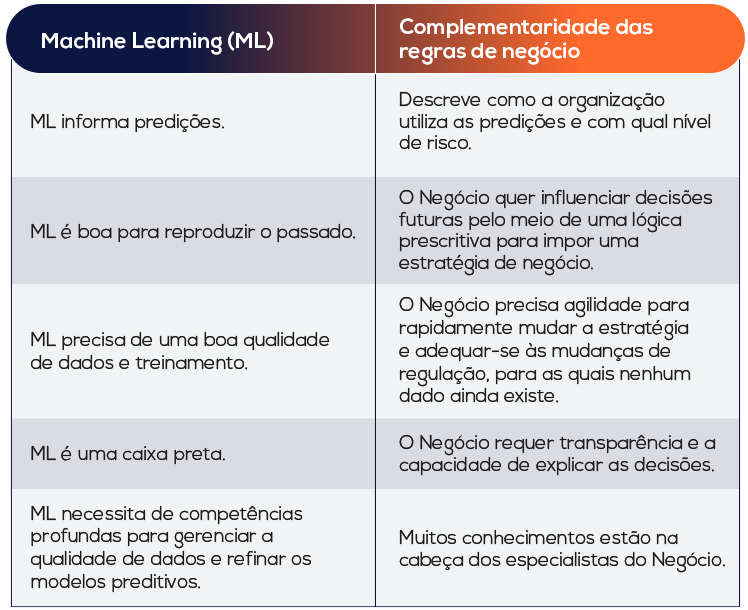

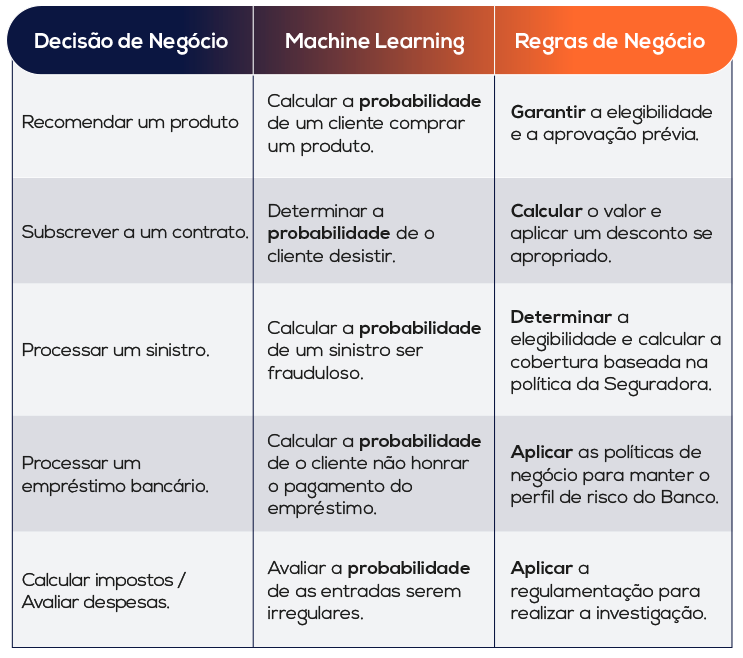

As duas tabelas a seguir apresentam a complementaridade das regras de negócio para o Machine Learning junto a alguns exemplos:

Casos de uso

Alguns exemplos de casos de uso de automação das decisões operacionais:

BANCOS E SERVIÇOS FINANCEIROS: subscrição e acompanhamento dos empréstimos, adequação dos serviços ao perfil dos clientes, avaliação de risco, investigação regulatória, elegibilidade de serviços e automação dos pagamentos.

SEGURADORAS: Processamento automático de sinistros, subscrição (novas propostas e renovação de apólices), detecção e investigação de fraudes.

VAREJO: Serviços de atendimento ao cliente com recomendação de produtos e serviços (personalização de oferta up-sell / cross-sell), aplicação dos programas de fidelidade, cálculo de comissões de venda.

INDÚSTRIA: Qualidade e controle da manufatura, investigação dos defeitos, manutenção baseada em condições.

SAÚDE: Processamento dos tratamentos e acompanhamento dos pacientes, processos de correspondência de doadores.

GOVERNO: Cálculo de imposto, aposentadoria, pensões, detecção e investigação de fraudes, processamento de reclamações.

Com IBM Operational Decision Manager, os especialistas de negócio utilizam uma plataforma Web para realizar atividades, que não precisam envolver profissionais de Tecnologia da Informação:

- Criar ou manter regras textuais ‘se... então... senão” e tabelas de decisão, utilizando um vocabulário de negócio;

- Revisar as lógicas de decisão, se necessário;

- Validar o que foi alterado, por quem, quando e por qual motivo;

- Testar, simular, gerenciar e governar os artefatos de decisão;

- Implantar as manutenções de regras no ambiente de Produção.

Se quiser saber mais sobre automação de decisões, pode contar comigo e com a equipe Scala.

Jerome Chartier

Advanced Analytics & Decision Management

-----------------------

Fontes:

IBM Impact 2020

IBM Decision Lab, Paris

Serverless: os prós e contras dessa opção de infraestrutura em nuvem

Serverless é uma arquitetura nativa da nuvem, que permite às empresas criar e manter seus aplicativos sem preocupação com a infraestrutura de servidores em que esses aplicativos estão rodando (por isso o “less” no nome).

Neste tipo de arquitetura, não é preciso se preocupar com tarefas como o provisionamento de servidor ou cluster, a aplicação de patches ou a manutenção do sistema operacional e do provisionamento de capacidade. As responsabilidades operacionais e de infraestrutura cabem ao provedor de serviços na nuvem, o que na prática aumenta a agilidade e a inovação.

Por que usar?

A arquitetura Serverless permite criar aplicativos modernos com maior agilidade e menor custo. E sem terem que se preocupar com a operação ou tempos de execução, podem se concentrar no produto principal, empregando tempo e energia no desenvolvimento de ótimos produtos, dimensionáveis e confiáveis.

Vantagens

- Custo

O modelo de preços de uma arquitetura Serverless é baseado apenas pela quantidade de computação e recursos utilizados. Caso o sistema esteja ocioso, nenhum custo será associado. Além disso, a maioria dos provedores de nuvem fornece uma camada gratuita de solicitações de função Serverless, sem mencionar outros serviços.

- Escalas fora da caixa

As infraestruturas Serverless aumentam e diminuem com base na demanda por funções específicas do sistema. Para os desenvolvedores, isso significa menos problemas e uma melhor experiência em picos de uso. Geralmente, os provedores de nuvem definem limites para simultaneidade máxima, de forma a proteger os desenvolvedores de custos descontrolados.

- Time to Market

Com Serverless, os desenvolvedores passam menos tempo provisionando, dimensionando e gerenciando a infraestrutura, liberando tempo para desenvolver uma lógica comercial de valor agregado. Além disso, o código da função geralmente é mais fácil e rápido de escrever, pois é conciso e deve ser projetado para fazer apenas uma coisa de cada vez.

Desvantagens

- Performance

O uso esporádico de serviços Serverless demanda a criação do servidor do zero (na hora de uma nova requisição) o que gera cold-starts da aplicação e ocasiona perda de performance momentânea.

- Limite de recursos

A computação Serverless não é adequada para algumas cargas de trabalho, como a computação de alto desempenho, devido aos limites de recursos impostos pelos provedores de nuvem.

- Monitorando e Depurando

Diagnosticar problemas de desempenho ou uso excessivo de recursos numa solução Serverless pode ser mais difícil do que com código tradicional de servidor, porque normalmente não se tem acesso à infraestrutura onde esses serviços são executados.

Casos de uso

A abordagem Serverless pode ser usada para uma ampla variedade de casos:

- Aplicações Web e Mobile

Um dos casos de uso mais comuns para Serverless, tende a criar APIs de back-end que atendem a aplicativos da Web e móveis. As APIs Serverless geralmente são fáceis de criar, gerenciar e funcionam bem em cenários de carga flutuantes.

- Processamento de fluxo e lote

A natureza orientada a eventos do Serverless é adequada para o processamento de dados. Por exemplo: as funções Lambda (AWS) podem ser designadas para consumir eventos de fluxos de dados ou definidas para processar tarefas em massa. Outro ótimo exemplo de porque o modelo de cobrança por uso é atraente, embora com altas cargas, a computação possa ser mais com Serverless.

- Internet das Coisas

Os dispositivos que se conectam à Internet para ler ou gravar dados são um excelente caso de uso para Serverless. Serviços como Alexa e eletrodomésticos como o iRobot são usuários Serverless conhecidos.

- Manipulação de imagens e vídeos

Com Serverless é possível criar serviços de imagem e vídeo com melhor desempenho para qualquer aplicativo. Você pode usar também para fazer redimensionamentos dinâmicos de imagens ou alterar a transcodificação de vídeo para diferentes dispositivos de destino.

Os aplicativos contam cada vez mais com reconhecimento de imagem para melhorar a experiência do usuário: por exemplo, um aplicativo de comércio eletrônico que permite aos clientes fotografar a frente do cartão de crédito em vez de digitar os números manualmente.

Esta arquitetura faz sentido em vários tipos de cenários, porém tem que ter cuidado na hora de escolher este tipo de abordagem para sua solução, verificando muito bem os objetivos e principalmente as desvantagens de partir para o uso de Serverless.

Gabriel Asakawa

Gerente de Inovação

--------

Fontes:

https://en.wikipedia.org/wiki/Serverless_computing

https://www.ibm.com/cloud/learn/faas#toc-faas-and-i-mdyazIsb

https://www.bmc.com/blogs/serverless-faas/

https://www.serverless.com/learn/use-cases/

Análise de dados para previsão de demanda: Modelando o Futuro

A previsão de demanda é algo crítico para empresas no mundo inteiro e em todas as indústrias, como manufatura, bens de consumo, varejo, farmacêutica, automotiva, eletrônicos e finanças, entre outros.

Sua função é crítica porque não apenas diminui ineficiências no supply chain, como afeta todas as partes da empresa. A previsão de demanda, por exemplo, determina a quantidade de matéria-prima a ser comprada, a quantidade de produtos a ser produzida, o número de produtos a ser entregue, o número de pessoas a se contratar ou o número de plantas a se construir.

ESTIMATIVAS

A análise preditiva permite não apenas estimar a demanda, mas também entender o que impulsiona as vendas e como os clientes provavelmente se comportarão sob certas condições.

Já a previsão de demanda é a estimativa de uma provável demanda futura de um produto ou serviço, enquanto o planejamento da demanda é um processo mais amplo que começa com a previsão, mas não se limita apenas a ele.

MAIOR PRECISÃO

Chegar o mais próximo possível da realidade é a chave para melhorar a eficiência em toda a cadeia de suprimentos. Mas, como alcançar a maior precisão possível? É aí que entram a previsão estatística tradicional e os algoritmos de aprendizado de máquina.

A previsão estatística tradicional é a abordagem mais popular para prever as vendas. As soluções de planejamento de demanda, baseadas em técnicas estatísticas, se integram perfeitamente ao Excel e aos sistemas existentes de Enterprise Resource Planning (ERP), sem a necessidade de conhecimento técnico adicional. Os sistemas consideram a sazonalidade e as tendências do mercado e a partir disso aplicam vários métodos para ajustar os resultados.

ABORDAGEM AMPLA

Para ajudar a descobrir o que pode acontecer no futuro, o software de análise preditiva executa o seguinte conjunto de operações:

- Agrega os dados históricos de diferentes fontes, incluindo sistemas de ERP e Customer Relationship Management (CRM).

- Faz a limpeza e tratamento dos dados.

- Determina qual algoritmo de previsão se adapta melhor ao produto.

- Constrói modelos preditivos para identificar resultados prováveis e descobrir relações entre vários fatores.

As ferramentas de análise preditiva permitem que as empresas combinem informações da empresa com importantes indicadores econômicos, eventos promocionais, mudanças climáticas e outros fatores que afetam as preferências do cliente e as decisões de compra. Facilita a identificação de novas oportunidades de mercado e gera insights mais granulares sobre a demanda futura.

DESAFIO

A previsão de demanda é uma tarefa desafiadora. Porém, com a adoção de ferramentas de análise preditiva, pode-se reduzir a lacuna entre antecipação e realidade. Contudo, por mais inteligente que seja a solução de previsão, as principais decisões ainda estão no capital humano.

Os especialistas do setor precisam definir quais fatores devem ser considerados em seus modelos preditivos. A lógica humana ainda é necessária para avaliar a relevância dos resultados produzidos pelos modelos preditivos e para extrair os insights obtidos pelos sistemas.

Aproveitando o que a inteligência artificial e a humana oferecem, podemos visualizar e planejar um futuro melhor para o nosso negócio.

Rogério Rocha, Data Scientist